En una evaluación tan enorme como PISA es muy fácil cometer involuntariamente algún error técnico en un país o dato importante. En el ámbito científico, tan natural como cometerlos debería ser el reconocerlos y rectificarlos, pero muy a menudo los egos y los prestigios de las instituciones se interponen, y los fallos se tienden a tapar. En mi opinión, no es cometer fallos lo que te hace poco fiable, sino cómo reaccionas cuando eres consciente del error. El caso es que, en las seis ediciones que llevamos de PISA, la OCDE ha cometido por lo menos dos errores técnicos importantes en nuestro país. El primero fue en los resultados de Lectura en 2006, y el segundo en el Índice Socioeconómico y Cultural (ISEC, ESCS en inglés) de 2015. No ha rectificado ninguno, y sólo los han reconocido a nivel político y con la boca chica.

El error de 2006 tuvo como resultado una caída de 20 puntos en la prueba de Lectura con respecto a 2003, y que se saldó con un aumento de 20 puntos en 2009. Afectó a la media española y, de las comunidades que habían tenido muestra ampliada en 2003, perjudicó sobre todo a Castilla y León (21 puntos), menos al País Vasco (10 puntos) y apenas a Cataluña (diferencia no significativa). Políticamente apenas tuvo efecto alguno, salvo en Castilla y León, donde hubo cierto escándalo y se tomaron algunas medidas técnicas encaminadas hacia el fomento de la lectura en Primaria. En el conjunto nacional el dato aparecía por primera vez en el texto de la página 69 del informe, mientras que la tabla (pág. 71) aparecía sin comparar con 2003 –la especialidad de Roca, entonces director del Instituto de Evaluación y hoy presidente del Consejo Escolar del Estado, era sumergir los datos "inconvenientes" en el fondo de la hojarasca. El texto ya aludía a un posible error técnico (aunque por causas equivocadas) y aprovechaba para justificar alguna de las medidas de la recientemente aprobada LOE:

"El descenso relativo producido entre 2000 y 2006 y la comparación internacional justifican la propuesta realizada en la LOE de dedicar un tiempo específico a la lectura en todas las etapas y en las diferentes áreas y materias."

Cuando aparecieron los datos de PISA 2009, España creció 20 puntos, mientras que todas las comunidades con muestra ampliada en 2006 mejoraron sus resultados en Lectura (en ese año era, además, la competencia estrella[1]), encabezados por los 25 puntos de Castilla y León. Todo el mundo sacó pecho entonces y el asunto se olvidó. Si hoy vemos los datos, queda como una anomalía en la serie (gráfico 2.b, más abajo) y poco más (aunque en algún informe nacional de otros países he visto que ponen a España como ejemplo a seguir por su evolución en Lectura entre 2006 y 2015: aviados van). Mi hipótesis entonces fue que había un fallo en algún ítem de anclaje, pero entonces no tenía la competencia técnica necesaria para averiguarlo. En algún sitio me dijeron que la OCDE había reconocido el error en alguna reunión técnica, pero no me contaron cual era el problema concreto.

Qué es el ISEC y por qué es importante

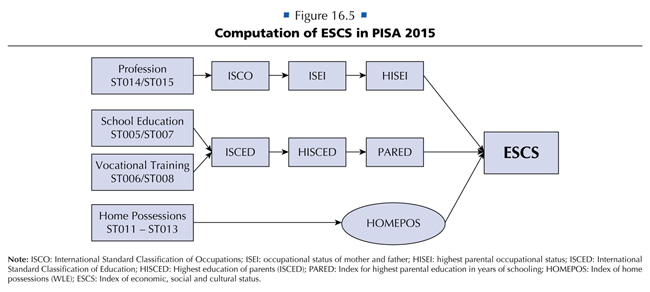

Como ya se ha dicho, el segundo error tiene que ver con el ISEC, o Índice Socioeconómico y Cultural, que es un índice complejo y, probablemente, la segunda variable más importante de PISA tras las escalas de rendimiento (Lectura, Matemáticas, Ciencias). Pero para entender el error antes hay que saber qué es esta variable, por qué es importante y cómo se obtiene (si ya la conoce bien puede saltarse este epígrafe, aunque los problemas que esconde el ISEC, detallados al final, probablemente le resulten menos familiares).

El ISEC es un índice compuesto que intenta recoger en un solo número el contexto socioeconómico y cultural de la familia del alumno, y que consta de tres elementos básicos: el nivel de estudios más alto de ambos padres, expresado en años de escolarización mínimos para la obtención de ese título en cada país (PARED); el estatus laboral más alto de ambos padres (HISEI), expresado en la escala internacional ISCO (International Standard Classification of Occupations en inglés, en español CIUO, Clasificación Internacional Uniforme de Ocupaciones); y otro índice denominado HOMEPOS (de "home possessions", bienes en el hogar en inglés), compuesto de 25 variables sobre lo que el alumno tiene en su casa, desde un diccionario al nº de coches o libros (la mayoría de las variables pueden verse en la carta enlazada un poco más abajo). Un cuadro detallado, obtenido de la página 340 del PISA 2015 Technical Report, es el que se reproduce a continuación:

Gráfico 1

La formación de un índice es un proceso matemático complejo que se puede realizar por varias vías (análisis de componentes principales, como es el caso del ISEC, análisis factorial o por medio de los modelos de la Teoría de Respuesta al Item, como es el caso de HOMEPOS), pero que básicamente tiene una serie de pasos comunes: se parte de una serie de datos numéricos directos, obtenidos generalmente de un test; estos se introducen en una función de cálculo compleja para obtener una serie de parámetros generales; con estos parámetros generales y los valores en el test de cada individuo se obtiene una puntuación particular para cada sujeto; en el caso de PISA, estas puntuaciones sufren una transformación adicional para que el conjunto tenga una media de cero y una desviación típica de uno. El objetivo de estos cálculos y transformaciones es averiguar qué importancia tiene cada variable inicial en la variable final, y emplear tal información en el cálculo del índice para cada individuo.

Entiendo que esta explicación puede ser un lío para aquellos poco familiarizados con estas técnicas, y muy básica para aquellos que ya las conocen, pero eso es algo difícilmente evitable. Para intentar desliar a los primeros, dejo una explicación más práctica en la segunda nota ([2]),pero creo que esto basta para comprender el proceso y entender dónde puede estar el error.

El ISEC tenía la particularidad de tener media cero y desviación típica uno en cada una de las ediciones de PISA, pero esta característica significaba que ese índice no era comparable de una edición a otra, y no se podía utilizar como variable de tendencia como las de rendimiento (es decir, se podía comparar el resultado de Matemáticas de una edición a otra, pero no el ISEC). Para solucionar este problema, la OCDE recalculó para la edición de 2015, el denominado "ISEC de tendencia" (ESCS trend, que puede encontrarse aquí, en el apartado Rescaled Indices for Trend Analyses). Para ello tomó como base los datos de 2015 y utilizó esos parámetros para recalcular los índices de todos los alumnos de las ediciones anteriores (el proceso es algo más complejo: quien quiera puede consultar los detalles en el capítulo 16 del PISA 2015 Technical Report, especialmente las págs. 339-342). El resultado de este sistema es que el ISEC es comparable no sólo entre países (o alumnos) dentro del mismo año, sino que se puede seguir la tendencia de un país a lo largo de las ediciones, o equiparar los datos de un país en un año determinado con los de otro país en otra edición de PISA.

Pero el cálculo del ISEC tiene algunos problemas:

1. Definición y elección de variables. Aunque el nivel de estudios y el estatus laboral aseguran buena parte del estatus socioeconómico y cultural, las variables pequeñas que forman la otra pata del ISEC afinan el cálculo, ordenan dentro de las mismas categorías. Sin embargo, aunque todas las variables contribuyen al índice (si no, no estarían ahí), pueden existir otras variables que contribuyan al índice en mayor medida, mejorándolo. Hay que tener en cuenta que estas variables se eligieron a finales del siglo pasado, y que entonces no parece que hubiera un proceso serio de selección de variables con criterios técnicos, como mucho ha habido un cierto filtrado con el tiempo.

2. Significación de las variables. Algunas variables no significan lo mismo no sólo entre países, sino dentro del propio país. Por ejemplo, en el cuestionario se pregunta por el número de baños en casa, pero es bastante cuestionable que sea lo mismo tener tres baños en una casa en el centro de una gran ciudad que en una vivienda situada en un poblachón manchego. De hecho, sólo los tienen el 11,8% de los alumnos vascos o el 11,3% de los catalanes, por un 26,8% de los castellano-manchegos, por poner los extremos, cuando es evidente que el nivel de vida en las dos primeras es sin duda superior al de la tercera. Es una variable que funciona a escala municipal (es probable que si hay dos viviendas familiares en un mismo municipio o barrio, una con tres baños y otra con uno, la diferencia se deba al poder adquisitivo), pero no tiene por qué a escala regional ni tengo claro que a escala nacional (probablemente sí si comparamos España con Túnez, pero no si comparamos nuestro país con Alemania o Gran Bretaña).

3. Caducidad de las variables (tendencia). Ya he dicho anteriormente que las variables que sirven para calcular el ISEC se decidieron a finales del siglo pasado, y lo que entonces podían ser artículos más o menos exclusivos, hoy no tiene por qué ser así. Quizás el caso de los móviles sea el más evidente: en 2000 sólo el 16% de los alumnos españoles de 15 años tenía tres o más móviles en casa, mientras que en 2015 eran el 86%: ¿de verdad tal aumento corresponde a una elevación del nivel de vida o a los procesos propios de una saturación del mercado?

4. Capta mal las coyunturas. Quizás esta parte puede sorprender, aunque tiene cierta lógica. El ISEC no es sensible a las crisis coyunturales, como la que ha pasado nuestro país, entre otras cosas porque intenta capturar el entorno socioeconómico del estudiante a lo largo de su escolarización, pues se supone que es el que más pesa en el rendimiento. Por ejemplo, si uno de los progenitores se ha quedado en el paro a PISA le da lo mismo, pues pregunta por las características de su último trabajo, aunque ya no lo tenga. Por supuesto, el nivel educativo de los padres no cambia con la crisis (por tanto, dos tercios del índice apenas se mueven). Las variables que más tienen que ver con el nivel económico apenas se verán afectadas a corto plazo: las familias en crisis a lo mejor no tienen menos móviles o coches, sino que los tienen más viejos, etc.

Lucas Gortazar sugire en su The PISA "shock" in the Basque Country: Contingent factors or structural change? (pág. 11) que PISA debería ser más sensible a los cambios coyunturales, y que no hacerlo perjudica (o afecta) especialmente a los países del sur de Europa, y creo que tiene razón en que los cambios laborales de esa magnitud en una familia pueden afectar negativamente al rendimiento del alumno. Pero también pienso que PISA no está para eso. Es cierto que preguntar si algún progenitor se ha quedado en paro y desde cuando no vendría mal, pero nos olvidamos de que PISA es un complemento a los deberes que tendríamos que hacer en casa y que, evidentemente, no hacemos. Los deberes son, claro, tener un sistema decente y transparente de evaluación nacional del sistema educativo, adaptado a lo que necesitamos para entender nuestros problemas.El segundo error técnico

Este Índice Socioeconómico y Cultural no es uno de tantos datos que se recogen en la evaluación, sino la variable que más influencia tiene como predictor del rendimiento de todas las que PISA mide (y así será hasta que se atrevan a incluir, por ejemplo, la inteligencia). De hecho, es muy habitual "corregir" los resultados cognitivos de PISA con esta variable de contexto (a menudo, de forma abusiva) para comparar los resultados entre países, regiones o alumnos en "igualdad de condiciones" socioeconómicas. Por ejemplo, mi amigo Juan Carlos Rodríguez sostiene desde hace tiempo la tesis de que, dado que España está estancada en los resultados de Lectura, Matemáticas y Ciencias de todas las ediciones, y puesto que el contexto socioeconómico y cultural no ha hecho sino mejorar, en realidad ese estancamiento es un empeoramiento de los resultados. Es una tesis plausible, pero hasta que no se creó el ISEC de tendencia era difícil de comprobar fehacientemente.

Precisamente estaba trabajando en comprobar esta tesis, y si era cierta, de cuánto estábamos hablando, y estos son los resultados para las tres escalas cognitivas (las barras verticales en cada punto corresponden al error de cada estadístico para un intervalo de confianza del 95%; no está de más recordar que tal error sólo sirve para comparar puntos en la misma serie, no entre serie distintas) [como siempre, click para ampliar]:

Gráfico 2.a

Gráfico 2.b

Gráfico 2.c

Como se puede ver, el punto ponderado de 2015 está mucho más arriba de lo que la serie permite prever en todas las escalas. Entre 2000 y 2012, los resultados ponderados por el ISEC (línea rojiza en los tres gráficos) habían caído 19 puntos en Lectura (un cambio sustantivo), 8 en Matemáticas (no significativo) y 10 en Ciencias, pero entre 2012 y 2015 habíamos recuperado más de lo perdido de forma sorprendente. Y digo sorprendente porque, primero, nada había cambiado de forma sustantiva en el sistema educativo como para producir tal resultado (el axioma de que ningún resultado cambia si no has tomado medidas antes es raramente creído por nuestros administradores educativos; el que sólo cambia –a mejor, claro– tomando ciertas medidas muy concretas les parece de ciencia ficción), y segundo, porque los resultados sin ponderar (línea azul en los tres gráficos) tampoco lo explicaban. Antes de meterme con el ISEC hice algunas comprobaciones adicionales: eliminar a los inmigrantes empujaba la serie hacia arriba, pero la tendencia continuaba igual; al comprobar el archivo de los datos regionales de España (en esta edición están separados), el salto de 2015 se mantenía incluso región a región. El sospechoso se mantenía y, efectivamente, se comportaba de forma extraña, como puede verse en el siguiente gráfico (línea azul para el ISEC de tendencia):

Gráfico 3

Ese cambio es una auténtica enormidad, no creo que tenga parangón en tan sólo tres años. Nada menos que una caída de 0,64 puntos (para una desviación típica de 1 de este índice para toda la OCDE). Para que se hagan una idea menos técnica, habíamos pasado de estar al nivel de Francia en 2012 al de Jordania en 2015. Y es cierto que hemos pasado una dura crisis, pero ni de tal magnitud, ni ha afectado sobre todo a la franja de edad que puede tener hijos de 15 años, ni el ISEC está planteado para capturar situaciones coyunturales (como ya hemos visto). Sencillamente, no podía ser. El caso es que, el mismo mes en que salieron los datos de PISA 2015 (diciembre de 2016) hice unos cálculos de urgencia y envié una carta a la OCDE de cinco páginas (aunque más de tres corresponden a tablas y gráficos) en la que explicaba por qué el dato español no era verosímil. Una traducción de la carta puede leerse aquí (el texto estaba en inglés, sólo se ha cambiado el nombre de la persona a la que iba dirigida). No recibí respuesta y me olvidé de ello: instituciones e investigadores tiene la Iglesia, ya se ocuparán.

Mientras he sabido, aunque no oficialmente, que el Instituto de Evaluación[3] (INEE), el interlocutor español con la OCDE en estos temas, ha hecho gestiones en el mismo sentido y, aunque en ese caso la macroorganización ha tenido a bien contestar, la respuesta ha sido, por decirlo castizamente, lentejas. Por otro lado, en los casi tres años transcurridos, y aunque he leído no pocos informes y artículos científicos donde han utilizado esta variable, todo el mundo parece actuar como si el error no existiera.

Profundizando en el error

Por razones que no vienen al caso he tenido que retomar el tema del error en el ISEC español, y podía elegir entre dos opciones: o reconstruir el proceso para encontrar el error, o buscar una vía alternativa que mostrase claramente el fallo. Dado que el proceso está descrito algo someramente en los documentos de la OCDE, que no tengo tiempo de ponerme a ello, y que mi ordenador actual (el año que viene me toca comprar uno nuevo) no creo que tenga la capacidad de proceso necesaria, me decanté por la segunda opción, bastante más sencilla (al final, una función de poco más de 20 líneas de código, no muy eficiente, pero que trabajaba en segundo plano): comparar los alumnos con los mismos parámetros que sirven para calcular el ISEC en nuestro país y en el resto de la base de datos de PISA.

La idea es que los alumnos con los mismos datos iniciales (los obtenidos de los test) tienen que obtener el mismo ISEC. Por complejo que sea, el cálculo de un índice es un proceso matemático, lo que significa que si partes de los mismos parámetros llegas a los mismos resultados. Por tanto, fui comparando el ISEC de los alumnos españoles con el del resto de la OCDE con los mismos parámetros iniciales –nivel de estudios de los padres, estatus laboral de los mismos y el índice HOMEPOS (los dos primeros exactos, el tercero en intervalos de una décima de índice)– y luego comparé el ISEC de ambos grupos. Ya puestos, hice el mismo proceso con los otros datos de España (en 2015 España tiene dos grupos de datos: uno que representa a España como país y otro con los datos de la muestra ampliada de todas las CCAA) y con otros países de nuestro entorno.

Estaba en este proceso cuando reparé en la nota 10 al final del capítulo del PISA 2015 Technical Report (pág. 343), donde puede leerse lo siguiente:

10. In October 2016, it turned out that the PARED variable was coded incorrectly for Spain, Lebanon and Latvia. As a consequence, the ESCS calculation was based on incorrect variables in some of the countries. To avoid changing the values of ESCS for all countries, at a time where most reports were already completed, ESCS was recalculated only for the samples with mistakes in the original PARED values, using the results from the international ESCS calculation (i.e., constants for standardizing input variables, factor loadings, eigenvalue, and constants for standardising the ESCS). As a consequence of this partial recalculation, the ESCS mean across OECD countries is no longer exactly zero and the standard deviation is no longer exactly one. Instead, the respective descriptives are -0.0259 and 1.00001.

Vamos, supongo que lo clásico que los españoles pensamos que sólo ocurre en nuestro país, pero que por lo que parece ocurre también en el resto: en octubre de 2016 (a poco más de un mes de que se publiquen los resultados de PISA, se compartan las bases de datos y se publiquen los primeros tomos de análisis) alguien se da cuenta de que hay un error en una variable fundamental (PARED, que indica el nivel educativo más alto de los padres expresado en años de estudio) para el cálculo del ISEC en España, Letonia y el Líbano; los de arriba entran en pánico y el marrón va resbalando hasta los curritos de turno con el clásico "lo quiero para ayer"; con las prisas, las variables escogidas para el cálculo no son exactamente las mismas que las que se han utilizado con el resto, se tira para delante, nadie comprueba nada y el resultado es el que tenemos en el gráfico siguiente:

Gráfico 4

Es un gráfico difícil de entender a primera vista, pero no es complicado. Se ha calculado el ISEC de los alumnos de cada país (rojo) con el ISEC de los alumnos de la OCDE que tienen los mismos parámetros (azul). Así, si la puntuación fuera igual en el país que en el resto de la OCDE, los puntos rojos estarían en la diagonal del cuadrado, pero no es al caso. Lo que vemos es que hay una desviación de las puntuaciones, y que esta no es lineal, sino que va aumentando según disminuye el ISEC (de hecho, es nula cuando el ISEC es superior a 1,5, pero alcanza el medio punto cuando el ISEC se acerca a -2,5. La desviación total para España es de alrededor de tres décimas de punto.

En el resto de países (aquí les pongo cuatro de ejemplo, pero lo he comprobado en la cincuentena restante) no existe tal variación al aplicar el mismo método, y todos los puntos están en la misma diagonal:

Gráfico 5

Es un error importante, pero no explica toda la desviación, sólo una parte. Sospecho, basado en el artículo de Gortázar antes citado, que también hay un error en el cálculo del índice HOMEPOS (la tercera pata del ISEC), ya que no parece haber variaciones importantes en este índice tampoco, al menos en el País Vasco. Y puede haber más fuentes de error, mi apreciación personal es que es muy difícil que el ISEC español en 2015 esté por debajo de cero, pero eso sólo puede confirmarlo un recálculo del índice completo.

Nos queda por dilucidar otra cuestión: si todos los índices se han calculado basándose en los datos de 2015, ¿se podría haber arrastrado el error a los otros años? Pues puede que algún fallo menor se haya cometido, pero el error grueso antes descrito no parece que se haya trasladado a otras ediciones de PISA. Sólo he hecho alguna comprobación menor, pero como se muestra en el gráfico 6, al menos para la edición de 2009 en los países afectados (muestro sólo España y Letonia, pero tampoco en el Líbano hay desviación) no parece haber problemas.

Gráfico 6

No se me entienda mal: no estoy, ni mucho menos, con los que piensan que PISA carece de rigor ni ha de ser tomado en cuenta. Estos errores técnicos no invalidan en absoluto ni su trabajo ni sus resultados. Mi queja con la OCDE es otra: tiene que ver con lo que tiene de "ciencia áulica", uno de los mayores peligros (en mi opinión, claro) que tiene la ciencia hoy día; y con las libertades que se toman para ir más allá de lo que sus datos les permiten ir.

Notas:

[1] Cada edición de PISA tiene una competencia que se evalúa más en profundidad y pasa a ser la más importante. La Lectura lo fue en 2000 y 2009, y lo volverá a ser en 2018. Se van turnando, con Matemáticas y Ciencias, cada nueve años, o cada tres ediciones. [subir^]

[2] Intentaré poner como ejemplo un proceso más práctico para el cálculo de HOMEPOS, una de las tres partes del ISEC. La OCDE quiere una variable o índice que resuma los bienes que existen en el hogar donde vive el alumno, que son a su vez reflejo del nivel económico y cultural de su hogar, pero no existe un termómetro que mida tal cosa. Por ello elige una serie de rasgos observables y que pueden ser contestados por el alumno. Por ejemplo, si tiene o no un diccionario en casa (entre otras muchas cosas), el número de móviles o cuartos de baños en su hogar, o el número de libros. A cada variable observable le da un número: 0/1 si carece o tiene diccionario; de 1 a 4 entre no tener móvil en casa y tener tres o más; de 1 a 5 dependiendo del número de libros que haya en la vivienda (por ejemplo, el 1 significa entre 0 y 25, y el 5 más de 500), etc. La idea es que el número de libros es un indicador de nivel cultural, y el número de móviles puede mostrar el nivel económico, pero ¿cuánto debe contribuir cada variable al cómputo del índice? Lo que hace el primer proceso de cálculo es asignar pesos (es decir, conceder importancia) a cada variable dependiendo de lo que contribuya al índice final, y esos pesos son los parámetros generales de los que hemos hablado antes. El segundo proceso de cálculo usa esos parámetros para pasar de los datos observables obtenidos del test de cada alumno (por ejemplo, el estudiante tiene: 0,1,1,1,1,0,0,0,2,3,1...) a un número (por ejemplo, 1,4771) perteneciente a una variable continua que, supone PISA, es un reflejo fiel de la variable que pretendíamos medir. El último paso es convertir la variable a otra que tenga media cero y desviación típica uno, con lo que nuestro número aparece en la base de datos como -0,2317. Este número ya nos dice que el alumno tiene un ISEC algo inferior al de la media de la OCDE, y que si la media de su país es -0,8, en realidad tiene un estatus medio-alto con respecto a sus connacionales. El sistema es aún más complejo (en realidad en el sistema actual se manejan probabilidades y no solo pesos para calcular HOMEPOS), pero basta para hacerse una idea.[subir^]

[3] He estado haciendo recuento y, en los casi diez años que mantengo este blog, he citado al Instituto de Evaluación con varios nombres distintos (de hecho, ya lo llamo Instituto de Evaluación siempre, tenga el nombre que tenga) y lo he referenciado a cuatro direcciones web, sea por cambio de nombre del Instituto, sea por el cambio de nombre del Ministerio. Además, con cada cambio de web desaparecen cosas, o al menos he sido incapaz de reencontrarlas. Esto significa que no tardando mucho, este enlace se habrá roto de nuevo. En fin.[subir^]